- 亿玖动态

- 行业资讯

NVIDIA Rubin CPX:超长上下文AI推理的算力架构革新

发布时间:2025-09-11

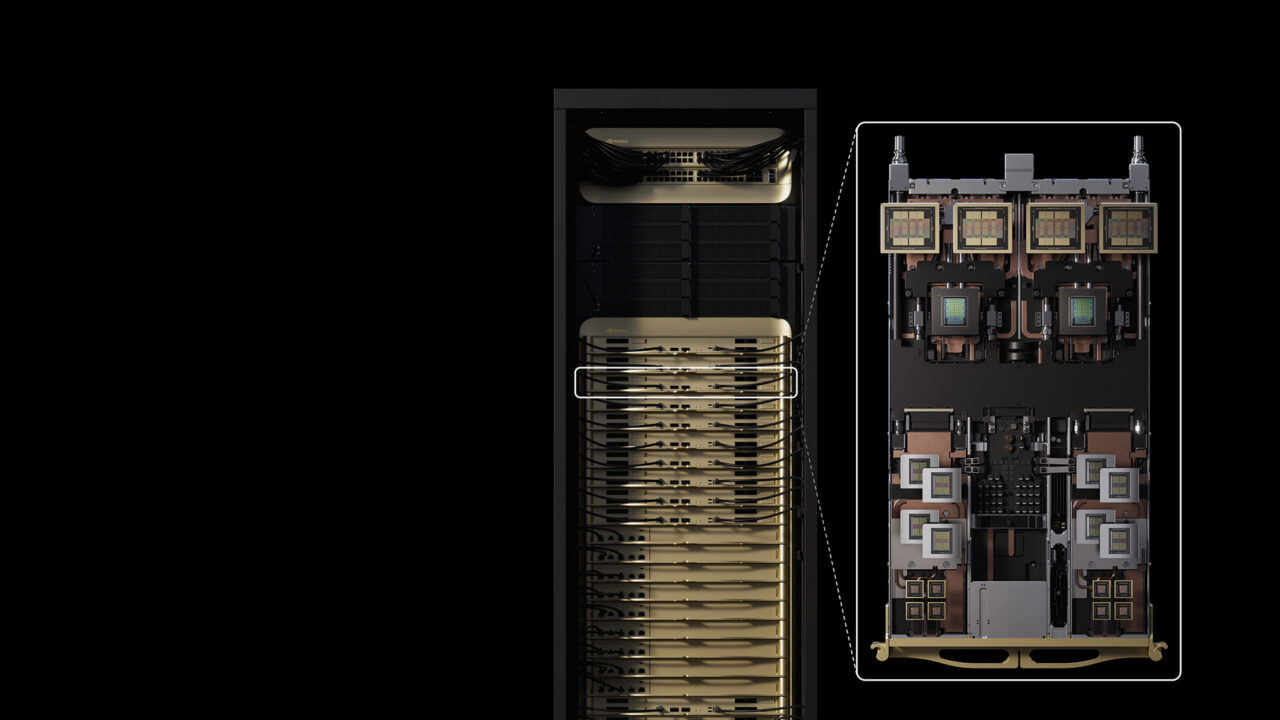

9月10日,NVIDIA正式发布面向超长上下文AI推理场景的定制化协处理芯片Rubin CPX,计划于2026年底实现量产。该芯片并非通用型加速器,而是专为百万级token长度的上下文处理任务设计,其128GB GDDR7显存架构支持单卡高效处理超长输入序列,显著突破传统GPU在长文本推理中的内存瓶颈。在NVFP4精度下,Rubin CPX提供30 PFlops的算力。

Rubin CPX的核心创新在于与主Rubin GPU的协同工作模式:CPX专注高吞吐量的上下文阶段处理,快速完成海量输入数据的特征提取与关联分析;主GPU则聚焦高带宽的生成阶段,确保输出token的连续高效生成。这种分工机制有效解决了传统推理架构中资源错配问题,使整机算力利用率提升300%,大幅降低推理延迟。

在Vera Rubin NVL144整机架架构(配置144颗Rubin GPU与144颗Rubin CPX协处理器)中,系统算力达到8 ExaFlops,内存容量100TB,内存带宽1.7 PB/s,较上一代GB300 NVL72系统性能提升6.5倍。NVIDIA实测数据表明,数据中心部署1亿美元的Rubin CPX系统,可带来约50亿美元的新增收入,主要源于视频预处理时间从分钟级压缩至秒级(如10万行代码处理延迟从5-10分钟降至数秒),以及资源解耦带来的总体拥有成本(TCO)显著优化。

Rubin CPX的推出标志着NVIDIA将超长上下文推理正式纳入独立算力赛道,为2026年后高分辨率视频生成、大规模代码模型推理及智能体系统应用提前构建了基础设施。

关键词: